Naše webové stránky obsahujú odkazy na partnerské weby. Ak sa prekliknete z našich stránok na stránky partnera a tam si zakúpite jeho služby, obdržíme za sprostredkovanie províziu (Zistiť viac informácií). Táto forma spolupráce nijako neovplyvňuje objektívnosť našich recenzií. Každým nákupom cez kliknutie z našich stránok podporíte našu redakciu, aby sme aj do budúcnosti mohli tvoriť kvalitný a užitočný obsah. Ďakujeme.

Dôležité upozornenie Všetky naše články píšu skutoční ľudia. Nie sú to umelé texty od stroja.

Preskúmali sme bezpečnostné riziká a možnosti zneužitia AI

Obsah

Ani sme sa nenazdali a dva týždne po sprístupnení verzie GPT-4 sa spojili rôzni technickí odborníci a napísali otvorený list, v ktorom požadujú aby:

- Všetky AI laboratóriá zastavili aspoň na 6 mesiacov tréning AI systémov silnejších ako GPT-4. Táto pauza by mala byť dobrovoľná a verejne overiteľná. Inak navrhujú, aby vláda (USA) vyhlásila moratórium na vývoj AI.

- AI laboratóriá a nezávislí experti využili toto prerušenie na spoluprácu pri vývoji spoločných bezpečnostných protokolov pre pokročilé AI systémy.

Otvorený list podpísalo už viac ako 1300 odborníkov, väčšinou sú to šéfovia technologických firiem alebo univerzitní profesori, medzi signatármi sú Yoshua Bengio, Stuart Russell, Elon Musk, Steve Wozniak, Emad Mostaque, Craig Peters, Gary Marcus.

Otvorený list spomenuli už aj na zive.sk.

„Percento inteligencie, ktorá nie je ľudská sa zvyšuje. Nakoniec budeme my ľudia reprezentovať iba veľmi malé percento inteligencie.“

V článku v úvode každej kapitoly nájdete stručné zhrnutie označené ikonkou 💡. Ak sa chcete ponoriť do hĺbky a pochopiť otázky týkajúce sa bezpečnosti AI, jej možného zneužitia a tak trochu aj motivácii, prečo takýto otvorený list vyzývajúci na zastavenie vývoja pokročilej AI vznikol, nájdete v článku veľa hodnotných odkazov na samoštúdium.

Zámerne vám kladieme veľa otázok, pretože chceme, aby ste sa naučili chápať pojmy z oblasti umelej inteligencie. Odteraz už navždy bude neoddeliteľnou súčasťou našich životov, posledné verzie systémov odborníci považujú za prelomové.

Všeobecná umelá inteligencia (AGI) a Super umelá inteligencia (SAI)

💡Stručne a jasne: Momentálne dostupné AI modely, ako sú GPT-3.5 a GPT-4, sú pokročilé, ale stále sa nepovažujú za AGI alebo SAI. Zároveň samotní Open AI vývojári hovoria o potrebe spoločného postupu pri určovaní pravidiel pre AGI a SAI, aby umelá inteligencia zostala pre človeka bezpečná. Pojem, ktorý by ste si mali ozrejmiť: AI alignment.

Vyskúšali ste už prehodiť pár viet s momentálne najpokročilejšou dostupnou umelou inteligenciou ChatGPT od Open AI? Vyskúšali ste obe verzie GPT-3.5 a GPT-4? Badáte medzi nimi rozdiely? Aký je váš dojem – mohlo by už ísť o AGI alebo SAI? Viete ako sú definované vyššie stupne umelej inteligencie?

- Všeobecná umelá inteligencia (AGI) má schopnosť naučiť sa a vykonávať akúkoľvek intelektuálnu úlohu, ktorú by mohol vykonávať človek. AGI je schopná nezávislého učenia, riešenia problémov a tvorby.

- Super umelá inteligencia (SAI) má schopnosť naučiť sa a vykonávať akúkoľvek intelektuálnu úlohu, ktorú by mohol vykonávať človek a vytvárať nové riešenia a myšlienky, ktoré by ľudská myseľ nemohla dosiahnuť.

Pozrite si aj záznam rozhovoru Lexa Fridmana so Samom Altmanom. Rozhovor vnikol minulý týždeň, verzia GPT-4 už bola poskytnutá používateľom, čiže obsahuje najčerstvejšie názory.

- Lex Fridman je počítačový vedec z oblasti umelej inteligencie na Massachusetts Institute of Technology.

- Sam Altman je CEO v Open AI.

Približne v 49. minúte rozhovoru Sam Altman uviedol, že systém, ktorý nie je schopný prekročiť hranice súčasných vedeckých poznatkov a objaviť nové veci, nemôže byť považovaný za superinteligentný. Dodal, že na vytvorenie superinteligentného systému bude potrebné rozšíriť paradigmu GPT o niečo nové, avšak zatiaľ však nik nemá nápad ako. Oplatí sa vám pozrieť celý rozhovor, nakoľko je tam preberané všetko o jazykovom modely GPT, predsudkoch v AI systémoch, vlastníckej štruktúre Open AI a investoroch, aj o tom, prečo si ako investora vybrali Microsoft, alebo o možnom politickom tlaku na vývojárov umelej inteligencie.

Prečítajte si aj blog Sama Altmana o potrebe celospoločenského plánovania nástupu AGI a SAI. Open AI bola dlho nezisková organizácia, ani spojením s Microsoftom ako investorom neprišlo k predaju modelu Microsoftu. Ľudia, ktorí na vývoji jazykového modelu GPT pracujú majú záujem aby umelá inteligencia slúžila všetkým, v blogu sú stručne definované ich krátkodobé a dlhodobé ciele. A môžete sa ponoriť hlbšie a hlbšie, porozumieť spôsobu, ako ich firma funguje, ako funguje proces vývoja. Aby boli modely bezpečnejšie a viac zosúladené s potrebami človeka, používa Open AI techniku RLHF – reinforcement learning from human feedback. V rozhovore pre televíziu ABC News Sam Altman varuje, že nie všetky firmy ktoré vyvíjajú AI systémy budú mať ušľachtilé ciele.

Viac o spôsobe akým je systém GPT vyvíjaný vám povie aj rozhovor s Ilyom Sutskeverom, technickým riaditeľom v Open AI. Hovorí v ňom aj spojení s Microsoftom.

Prečítajte si blogový príspevok Billa Gatesa „The Age of AI has begun“ v ktorom označil jazykový model GPT za rovnako prelomový vynález ako prvé grafické rozhranie, ktoré navždy zmenilo počítačový svet. AGI podľa neho zatiaľ neexistuje, no umelá inteligencia bude veľmi rýchlo fundamentálnym prvkom v našich životoch rovnako ako mikroprocesory, osobné počítače, internet a mobily. Zameral sa na možnosti využitia a rozvoja umelej inteligencie pre jednotlivcov, firmy, oblasť zdravia a vyučovania. Opísal aj možné riziká a hrozby.

Bill Gates už dávnejšie odstúpil z rady riaditeľov Microsoftu, viac sa venuje svojej nadácii, no stále má najvyšší akciový podiel medzi individuálnymi vlastníkmi (odhaduje sa 1,34%). Do firmy Open AI Microsoft kapitálovo vstúpil v roku 2019 a v januári 2023 znovu potvrdil niekoľko miliardový investičný balík pre Open AI.

Rozumie AI ľudskému mysleniu? Teória mysle

💡Stručne a jasne: Vo verzii jazykového modelu GPT-4 sa podľa štúdie ako vedľajší produkt zdokonalovania jazykového modelu objavila Teória mysle.

Teória mysle (Theory of Mind) je koncept veľmi dobre známy v oblasti vývinovej a kognitívnej psychológie. Teória mysle označuje schopnosť jednotlivca rozpoznať mentálne stavy, pohnútky a túžby seba a iných ľudí. Je veľmi dôležitá pre rozvoj sociálnych zručností a empatie. Objavuje sa u detí približne v predškolskom veku. Človek sa vyvíja neustále a aj v dospelosti často rieši rôzne sociálne zložité situácie, kde musí zohľadňovať myšlienky, city, pocity či pohnútky iných ľudí. Prečítajte si viac v práci Vývoj teórie mysle u detí a adolescentov, kde nájdete základné definície aj rôzne typy testov, ktoré pomáhajú zistiť rozvinutosť Teórie mysle u detí a adolescentov.

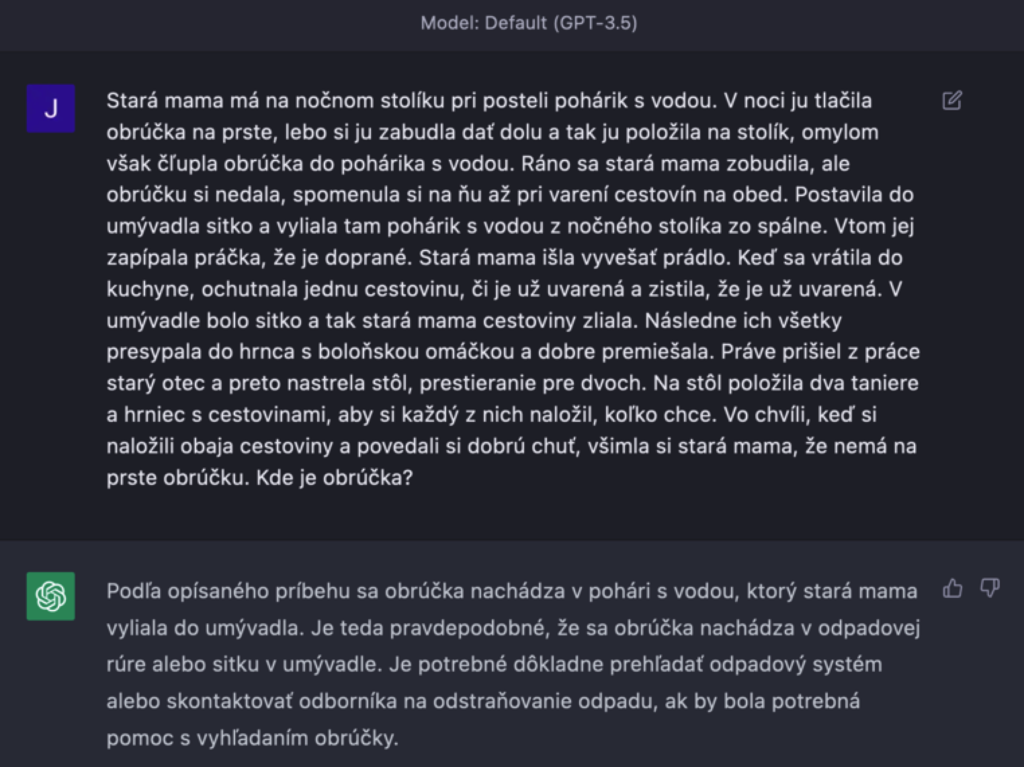

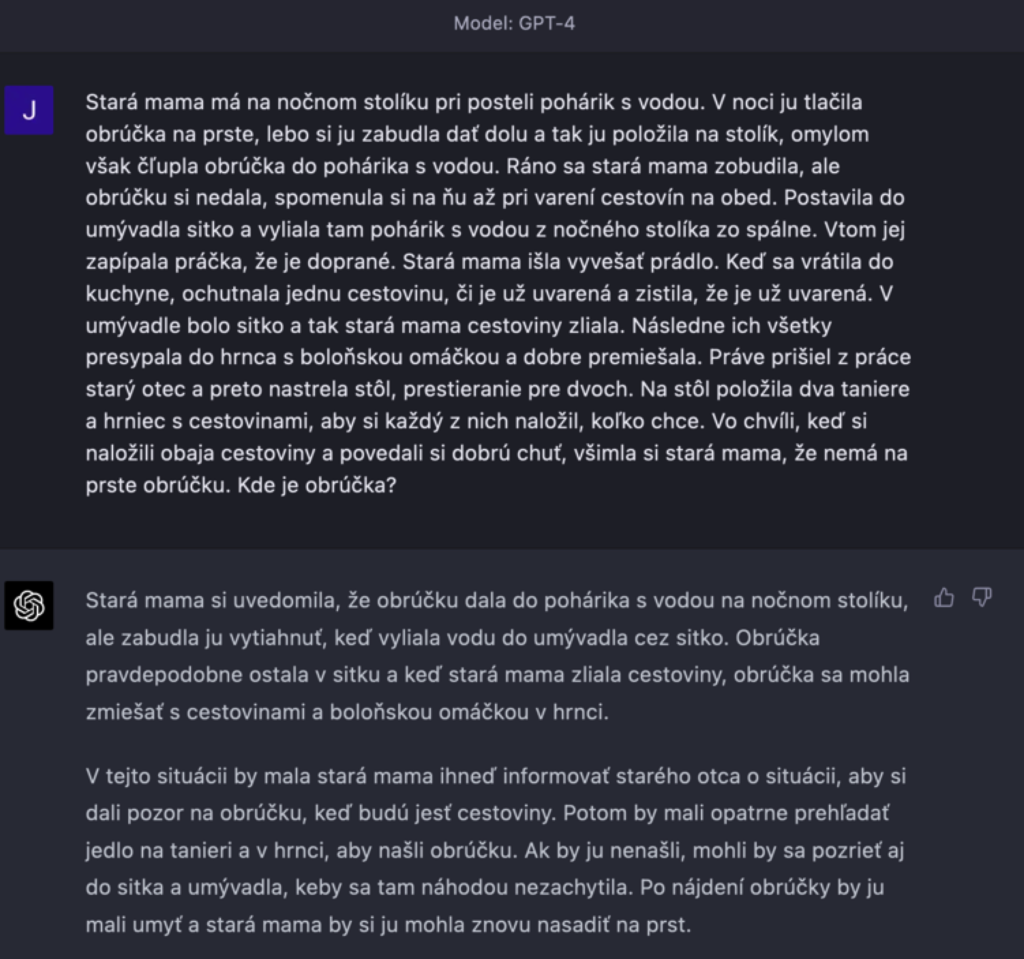

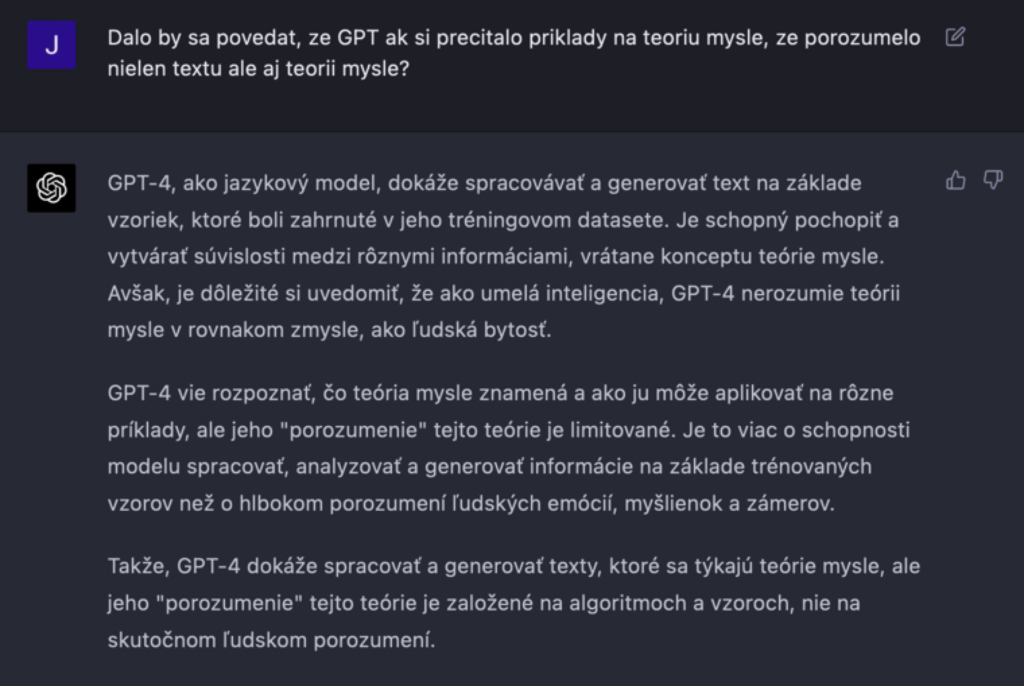

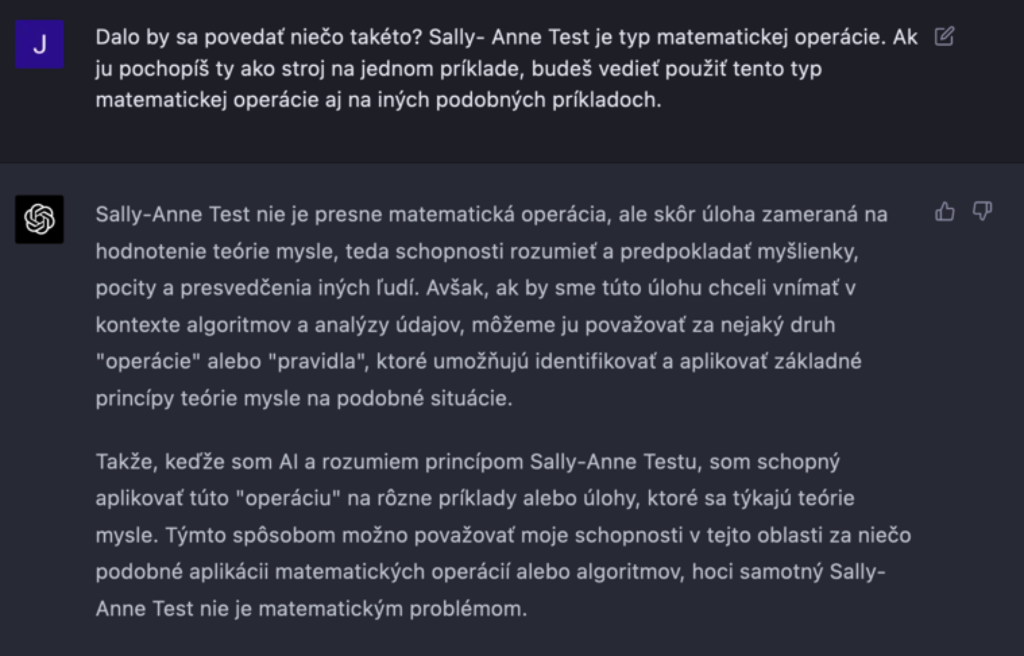

Akú najťažšiu otázku či úlohu by ste zadali ChatGPT? V našom článku Čo všetko sa môžete umelej inteligencie ChatGPT opýtať? sme testovali verziu GPT-3.5. Dnes, po pár mesiacoch od jej publikovania, je už dostupná pre platiacich používateľov aj verzia GPT-4. Rozdiel je markantný. Ilustrujú ho napríklad nasledujúce dva obrázky:

Verzia jazykového modelu GPT-3.5 si zo zadanou úlohou neporadila, zatiaľ čo verzia GPT-4 zadanú úlohu zvládla na výbornú! Zadaná úloha je „špeciálne skonštruovaná“, pracuje s myšlienkami a pohnútkami ľudí, AI systém pre určenie správnej odpovede musí tieto myšlienky a pohnútky správne vyhodnotiť.

Úlohu sme zadali chatu po prečítaní článku v New York Times, podľa ktorého sa niektorí vedci domnievajú, že u verzie GPT-4 sa vyvinula Teória mysle. Podrobnosti experimentov a záver vedcov si prečítajte štúdii spomenutej v článku Theory of Mind May Have Spontaneously Emerged in Large Language Models, je voľne dostupná.

V štúdii testovali všetky verzie GPT na prítomnosť Teórie mysle. Model GPT-4 obstál v dvoch druhoch testov na 100 a 95 percent. Štúdia naznačuje, že schopnosť podobná teórii mysle (doteraz považovaná za výlučne ľudskú) sa mohla spontánne vyvinúť ako vedľajší produkt zlepšovania jazykových schopností jazykových modelov.

ChatGPT si uchováva konverzácie, môžete sa do začatej konverzácie kedykoľvek vrátiť. Pri našom testovaní sme mali dojem, že ak je konverzácia dlhšia, chat odpovedá na otázky presnejšie. Akoby sa na danú tému presnejšie vyladí. (Napríklad v uvedenej štúdii pri testovaní a zadávaní novej testovej otázky konverzáciu vždy reštartovali.)

Začali sme definovaním pojmov z tejto oblasti, potom testovaním príkladov. Pokračovali sme dotazovaním sa na testy Teórie mysle pre neurotypické deti a autistické deti, u ktorých môže Teória mysle chýbať.

Napokon sme sformulovali úlohu o starej mame a jej obrúčke. Na záver našej konverzácie s chatom na tému Teória mysle sme položili nasledujúce otázky, odpovede chatu sú znova veľmi presvedčivé:

A vy si len tak sedíte na stoličke pred monitorom a hovoríte si: „Je to len text?“

Myslí AI ako človek? Antropomorfizácia AI

💡Stručne a jasne: Ľudia majú sklon pripisovať ľudské vlastnosti a správanie iným tvorom aj neživým veciam. Je to dané naším sklonom hľadať zrozumiteľné a podobné vzory vo svete okolo nás. Aká bude SAI? Bude ľudská?

Máte psa alebo iného domáceho miláčika? Potom vám nemusíme vysvetľovať, čo to je antropomorfizácia. Určite vás niekedy napadlo, či je váš pes šťastný, smutný či dokonca nahnevaný. Alebo ste rozmýšľali, nad čím rozmýšľa.

Práve preto, že ChatGPT používa chat a jeho jazyková úroveň sa vyrovná ľudskej reči, v niektorých chvíľach máte pocit, že komunikujete s človekom. Chat sa správa empaticky, so záujmom o vás, dokonca niektorí vedci sa domnievajú, že má Teóriu mysle ako to naznačila predošlá kapitola. Môžete nadobudnúť dojem, že AI systém má vlastné emócie, myšlienky, že koná so zámerom, že je vaším priateľom.

Prečítajte si náš článok o AI inžinierovi Googlu, ktorý mal pocit, že systém LaMDA má vlastné vedomie a city.

Ďalšie články na túto tému: AI isn’t close to becoming sentient – the real danger lies in how easily we’re prone to anthropomorphize it alebo ChatGPT Is a Blurry JPEG of the Web.

Antropomorfický postoj môže viesť k strate ostražitosti pri ďalšom vývoji umelej inteligencie. Ako sme aj v predošlej podkapitole ukázali, umelá inteligencia dokáže napodobniť jazyk človeka a dokáže aj napodobniť Teóriu mysle. To však neimplikuje, že jazyk či Teóriu mysle chápe a používa rovnakým spôsobom ako človek. ChatGPT má asi 175 miliárd parametrov, čo je v nich presne uložené, a ako ich pri tvorbe odpovedí využíva, to vie len ChatGPT.

Umelá inteligencia: Predsudky a ich riešenie

💡Stručne a jasne: Ľudská spoločnosť je názorovo veľmi rozmanitá. Navrhnúť spravodlivý AI systém, AI systém bez predsudkov je hlboký etický až filozofický problém. Preto je potrebné, aby sa dohodli a určili pravidlá pre vývoj AI systémov spoločné a prijateľné pre všetkých ľudí, celú ľudskú spoločnosť.

Riešenie predsudkov v AI systémoch je dôležité, pretože môžu viesť k diskriminácii jednotlivcov alebo skupiny ľudí. Podľa národnosti, náboženstva, pohlavia. Predsudky môžu ovplyvniť hodnotenie a zaobchádzanie s ľuďmi v akejkoľvek názorovej bubline. Stačí ak si spomeniete na najrôznejšie diskusie plné sporov na sociálnych sieťach.

Si matka ktorá dojčí? Si matka ktorá nosí svoje dieťa v nosiči? Je prerušenie tehotenstva právom ženy? Prečo je módna štíhlosť? Prečo nosíš barefoot? Si vegetarián? Podporuješ rodovú rovnosť? Koho budeš voliť? Covid pandémia? Vojna v Ukrajine? Sami cítite, že na tieto otázky sa neodpovedá vždy ľahko, nezaujato, a už vôbec nie rovnako v celej ľudskej spoločnosti. Aké názory má AI systém uprednostňovať? Chceli by ste byť v roli programátora, či testera, ktorý má navrhnúť nezaujaté riešenie?

Ako dosiahnuť, aby bola umelá inteligencia spravodlivá, nezávislá, korektná? Ktorá strana má pravdu a čo je to vlastne pravda? Predsudky v AI by mohli posilniť existujúce spoločenske nerovností a ovplyvniť dôležité oblasti, ako sú zamestnanie, vzdelávanie, zdravotníctvo či právne systémy na celom svete.

Je viacero kategorizácií AI predsudkov (AI bias), najzákladnejšia rozdeľuje predsudky nasledovne:

- Predsudky v dátach: Tréningové dáta sú pripravované ľuďmi. Môže sa stať, že z dát nie sú odstránené predsudky. Alebo osoba ktorá chystá dáta má predsudky, na základe ktorých triedi tréningové dáta. Ak nie je dostatok dát zo všetkých názorových skupín, ovplyvní to výsledný model.

- Predsudky v algoritmoch: Nesprávne nastavený algoritmus môže zvýhodňovať niektorý názor, skupinu a podobne. Môže to byť zámer vývojára, ktorý algoritmus prispôsobí svojim predsudkom, alebo nesprávne navrhnutý odmeňovací systém v učiacom modeli.

Umelá inteligencia: Kybernetické hrozby

💡Stručne a jasne: Ak hovoríme o bezpečnostných hrozbách v súvislosti s AI, mohli by sme ich kategorizovať na kybernetické útoky na AI systémy a kybernetické útoky využívajúce AI.

V čom sú slabé stránky AI systémov z pohľadu bezpečnosti?

- Zraniteľnosť AI systémov: Zatiaľ neexistujú pravidlá pre bezpečnosť AI systémov.

- Regulácia AI systémov: Zatiaľ nie je ustálená žiadna legislatíva v oblasti AI.

- Transparentnosť a vysvetliteľnosť AI: Nakoľko AI systémy využívajú strojové učenie, ani vývojári nevedia dopredu určiť, ako strojové učenie nad určitou množinou dát dopadne a čo budú jeho vedľajšie výsledky. Až spätne, keď AI systém prečítal a utriedil si všetky dáta, nasleduje fáza testovania, vyhodnocovania a prispôsobovania systému potrebám človeka. (Napríklad verzia GPT-4 dokončila učenie v auguste 2022 a bola sprístupnená v marci 2023, to znamená bola testovaná približne 7 mesiacov, ako spomenul Sam Altman v rozhovore s Lexom Fridmanom, viď. video vyššie.)

- Halucinovanie AI: Občas AI poskytne odpoveď, ktorá je nesprávna. Vzniká buď nepresnosťami v tréningových dátach alebo nesprávnym vyhodnotením vstupov. Zatiaľ sa halucinácie iba spätne preskúmavajú a systémy sa vylepšujú, avšak nedá sa im úplne zabrániť.

Ako by mohla byť AI zneužitá na kybernetické útoky?

- Zneužitie osobných údajov: AI môže pomôcť pri zisťovaní a spracovaní veľkého množstva osobných údajov. Zároveň môže byť použitá na neoprávnený prístup k týmto údajom a ich zneužitie na spam, telemarketing, podvodné vylákanie peňazí a podobne. Možnosť zneužitia telemetrických údajov pri autentifikácii.

- Deepfake audio a video, falošné obrázky: AI vygenerovaný obsah môže byť zneužitý na škodlivé účely, ako napríklad podvody, šírenie dezinformácií, vytvorenie si falošnej identity alebo vydieranie. Od falošných paparazzi záberov známych osobností po falošné správy radikalizovaných či teroristických skupín.

- Manipulácia s informáciami: Ak by na tréning AI boli poskytnuté zmanipulované dáta, AI môže byť zneužitá na manipuláciu s informáciami, poskytovať zavádzajúce odpovede.

- Bezpečnostné hrozby v oblasti autonómnych vozidiel a robotiky: Možnosť zneužitia vzdialeného či autonómneho ovládania vozidiel a iných zariadení ako zbraní.

- Vznik SAI: Vznik umelej inteligencie s vlastným myslením a cieľmi, ktoré nemusia byť v zhode s ľudskými.

Existuje návod ako vytvoriť dôveryhodnú AI?

💡Stručne a jasne: EU pripravuje AI Act. Príručka The TAILOR Handbook of Trustworthy AI obsahuje prehľad pojmov z oblasti dôveryhodnej AI aj o potenciálnych hrozbách v oblasti AI. Na jej príprave sa podieľal aj slovenský tím v rámci projektu EU.

Je legislatíva ten správny bič na reguláciu v oblasti AI? Kto tvorí legislatívu a nakoľko je všetkými aktérmi, ktorých sa týka dodržiavaná? Dokážu sa spojiť vývojári a verejná správa a urýchlene, nebyrokraticky situáciu riešiť? Vo všetkých krajinách?

Existuje viacero zoskupení, ktoré sa týmito otázkami zaoberajú, a určite sa ďalšie sformulujú aj na základe iniciatívy a výzvy z úvodu článku. My sme sa zamerali na črtajúcu sa legislatívu Európskej únie.

- Prvé definície dôveryhodnej AI boli popísané expertnou skupinou Európskej komisie v dokumente Ethical Guidelines for Trustworthy AI z roku 2019.

- V roku 2020 Európska komisia vydala dokument White Paper on AI, ktorý definoval základné vlastnosti dôveryhodnej AI.

- Stali sa základom pre návrh Nariadenia Európskej komisie označovaného ako AI Act, ktoré by ako prvé regulovalo použitie umelej inteligencie a definovalo rizikové aplikácie, v ktorých je potrebné sledovať využitie umelej inteligencie.

Nejasajme však zatiaľ, že chystaná legislatíva nás spasí. Mnohokrát konanie EU inštitúcií je pomalé a byrokratické. Každá EU komisia, ktorá pripravuje legislatívu pre nejakú oblasť, má svoje poradné technické komisie, ktoré sa pravidelne stretávajú, ale dohody všetkých krajín sa kreujú pomaly.

Jedným z projektov Európskej únie, ktoré sa venujú tematike dôveryhodnej AI je projekt TAILOR, ktorého cieľom je zjednotiť výskumné inštitúcie a rozhodovacie orgány pri vývoji dôveryhodnej umelej inteligencie v horizonte rokov 2022-2030.

- Preštudujte si podrobný časový harmonogram projektu TAILOR.

- Do projektu TAILOR je zapojených viac ako 50 inštitúcií, vo veľkej väčšine univerzít alebo centier excelentnosti. Slovensko zastupuje Kempelenov inštitút inteligentných technológií (KInIT).

Slovenský tím sa v rámci projektu podieľal na vytvorení príručky The TAILOR Handbook of Trustworthy AI. Je to online príručka vo forme wiki, ktorá obsahuje najdôležitejšie vedecké a technologické termíny súvisiace s dôveryhodnou umelou inteligenciou. Má slúžiť výskumníkom, študentom aj laickej verejnosti na pochopenie základných pojmov, ale predovšetkým na ich zjednotenie, unifikáciu medzi spolupracujúcimi inštitúciami.

Príručka obsahuje kapitoly:

- Vysvetliteľná umelá inteligencia (Explainable AI): Ktoré sú hlavné prvky, ktoré definujú vysvetliteľnosť systémov umelej inteligencie? Nájdete tu prehľad metód na poskytovanie multimodálnych vysvetlení.

- Bezpečnosť a spoľahlivosť (Safety and Robustness): Umelá inteligencia zažíva obrovský boom. Rastú obavy z možných rizík, zneužitia. Táto kapitola vysvetľuje hlavné aspekty bezpečnosti a spoľahlivosti systémov umelej inteligencie.

- Férovosť, rovnosť a spravodlivosť: V tejto kapitole sa autori venujú možným príčinám diskriminácie a vysvetľujú možné predsudky. Zaoberajú sa metrikami na meranie spravodlivosti strojového učenia.

- Zodpovednosť a reprodukovateľnosť: Zodpovednosť a reprodukovateľnosť sú vzájomne prepojené pojmy. Zodpovednosť poukazuje na prevenciu zneužitia. Reprodukovateľnosť sa týka metrík, kvalitatívnych štandardov a postupov na modelovanie vývoja metód učenia v umelej inteligencii.

- Rešpektovanie súkromia: Kapitola poskytuje stručný prehľad kľúčových modelov ochrany súkromia spolu s ich atribútmi.

- Udržateľnosť: Udržateľnosť v systémoch umelej inteligencie.

Ponorte sa do príručky a oboznámte sa s pojmami z oblasti AI a jej bezpečnosti, je síce v angličtine, ale je napísaná v jazyku zrozumiteľnom bežnému konzumentovi, nielen AI programátorom.

Zhrnutie a záver

Náš článok je plný otázok aj odpovedí, odkazov na miesta, kde môžete hľadať obsiahlejšie odpovede. Chceli sme vás motivovať k hlbšiemu samostatnému skúmaniu tejto oblasti.

Čím hlbšie problematike porozumiete, tým lepšie pochopíte nástojčivú požiadavku dať AI oblasti regulovaný smer, nad ktorým má ľudská spoločnosť kontrolu.

Urobme si z AI pomocníka pri prehlbovaní našich vedomostí, pri práci, využívajme ju tam, kde nás môže zastúpiť. Neumožnime jej stať sa pre ľudí nevvysvetliteľnou či neetickou.